Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 22.-23.Februar 2022, 07:05

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

Kontext

Bei diesem Beitrag handelt es sich um die Fortsetzung des Diskurses zu den zuvor besprochenen Artikeln von Popper: „A World of Propensities“ (1988, 1990), „Towards an Evolutionary Theory of Knowledge“ (1989,1990)[1] sowie „All Life is Problem Solving“ (1991, 1994/1999). [2]

Vorbemerkung

Nach einer ersten Kommentierung von drei Artikel von Popper aus den Jahren 1988 – 1991 soll hier der Versuch unternommen werden, aus den vielen Hinweisen, die diese Texte liefern, einen ersten Gesamteindruck zu formulieren, der Bezug nimmt auf bekannte Strukturen. Was damit genau gemeint ist, wird im Folgenden erklärt.[3]

Popper und der ‚Rest‘ – Ein erster Versuch

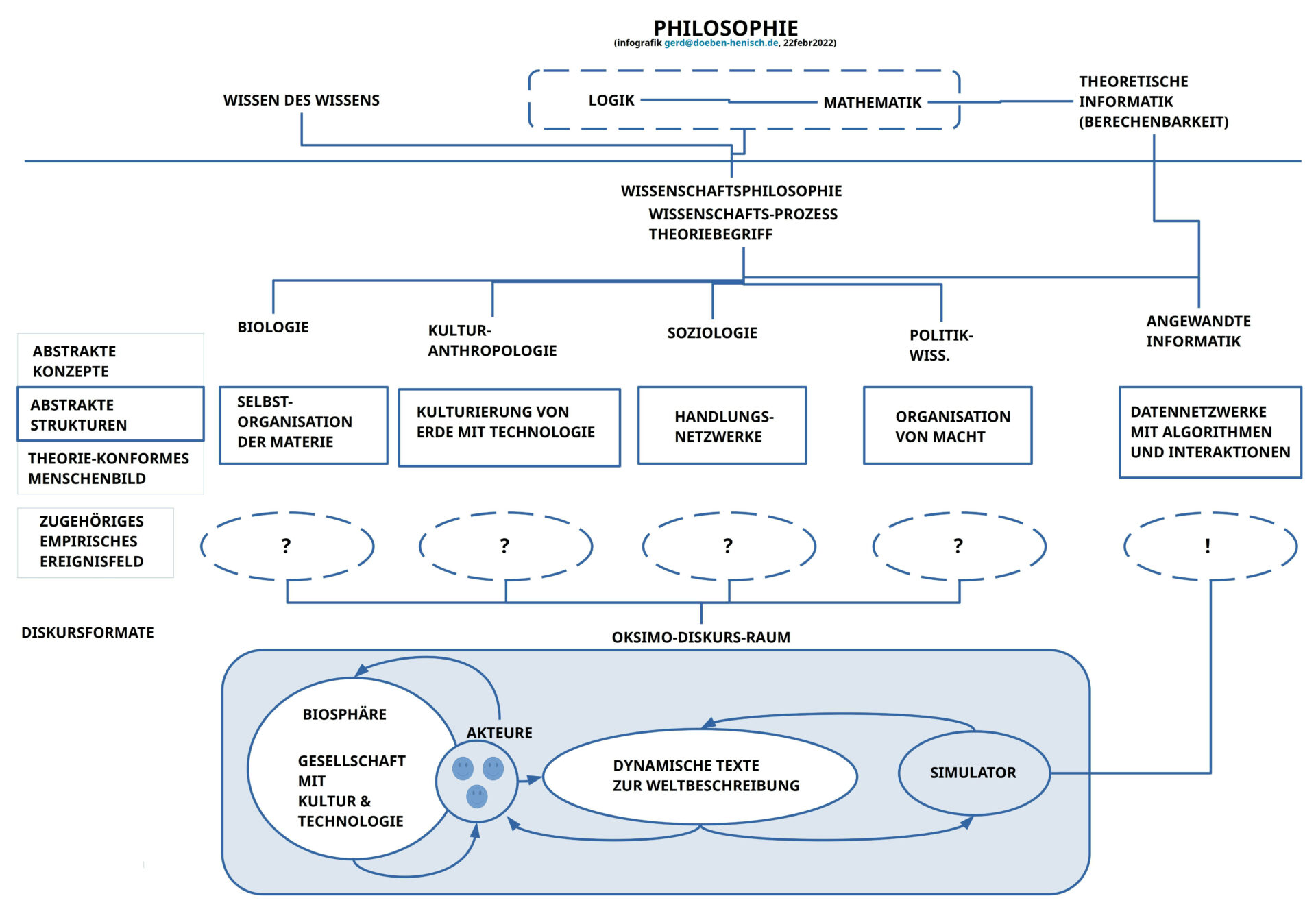

Das vorausgehende Schaubild deutet ein Netzwerk zwischen vielen Begriffen an. Gehen wir dies der Reihe nach durch.

Ereignisfeld – Objektive Tendenzen

Ausgangspunkt und dauerhafter Bezugspunkt für alle empirischen Wissenschaften ist das Ereignisfeld, in dem jeder Akteur mit seinem Körper vorkommt. In der Analyse des späten Popper verweisen Ereignisse auf reale Konstellationen, deren Wirkungen zu Ereignissen führen können. Da die auslösenden realen Konstellationen im Normalfall ein ganzes Bündel von Faktoren sind, die sich wechselweise beeinflussen, sind die resultierenden Wirkungen und damit die resultierenden Ereignisse niemals deterministisch, aber auch niemals rein zufällig. Ein solcher wirkender Faktor kann selbst wieder ein Wirkung sein. Solche Ereignisse nennt Popper ‚Tendenzen‘, also letztlich ‚Ereignisse als Wirkungen von realen wechselwirkenden Faktoren‘. In dieser Vorstellung ist implizit die Dimension ‚Zeit‘ enthalten und die Dimension ‚Raum‘. Eine ‚Interpretation‘ von Ereignissen als ‚Tendenz‘ geht immer von ‚Mengen von Ereignissen‘ aus, die zeitlich geordnet auftreten. Ferner setzt die Interpretation eines Ereignisses als ‚Tendenz‘ die Dimension ‚Vergangenheit‘ voraus (erinnerte Gegenwart), darin Eigenschaften wie ‚Häufigkeit‘ oder ‚übergreifende Muster‘ von ‚Korrelationen‘.

Ein solches ‚dynamisches‘ Ereignisfeld ist nach dem späten Popper grundsätzlich ‚offen‘ für unterschiedliche Arten von Zukünften. Eine Zukunft entsteht zwar in der Gegenwart, aber ihre ‚kommende Gestalt‘ liegt in Gemisch aus ‚Nichtdeterministisch und nicht rein zufällig‘.

Wissenschaftliche Disziplinen

Die radikale Offenheit und die absolute Unvollständigkeit des Ereignisfeldes erlaubt viele hypothetische Interpretationen. Die Vielzahl der heutigen einzel-wissenschaftlichen Disziplinen ist eine Auswirkung dieser Erkenntnissituation. Das Ereignisfeld sprengt in der ersten Annäherung jede mögliche Interpretation. Und selbst der Versuch, das ‚Suchfenster‘ für eine einzelne empirische Disziplin zu fixieren, bereitet Probleme. Es ist auch bislang keine einzige wissenschaftliche Disziplin bekannt, deren ‚Untersuchungsgegenstand‘ vollständig spezifiziert ist. Es handelt sich immer um mehr oder weniger gute Umschreibungen, illustriert durch Beispiele. Meine Charakterisierung des ‚Suchfensters‘ der einzelnen Disziplinen resultiert im Fall von Kulturanthropologie, Soziologie und Politikwissenschaft nicht aus historischen Studien zu diesen Disziplinen, sondern stellt eine ‚hypothetische Setzung‘ dar aufgrund systematischer Überlegungen. Mit Popper würde ich sagen, es handelt sich um ‚Hypothesen‘, die man empirische überprüfen kann. Im Fall der Biologie gehe ich von meiner bisherigen Lektüre biologischer Texte aus (Schwerpunkt Evolutionsbiologie), und im Fall Informatik ist es ein Fach, in dem ich gelehrt und geforscht habe. Das Gleiche gilt für die Themenfelder ‚Philosophie‘, ‚Logik‘, ‚Mathematik‘ und ‚Theoretische Informatik‘, in unterschiedlichem Umfang. Andere Fächer, in denen ich gearbeitet habe wie z.B. ‚Linguistik‘, ‚Phonetik‘, ‚experimentelle Psychologie‘, ‚Hermeneutik‘, und ‚Semiotik‘ habe ich in dem Schaubild nicht berücksichtigt.

Mit Blick auf die Biologie habe ich einfach mal geschrieben ‚Selbstorganisation der Materie‚. Manche Biologen würden vielleicht sogar zustimmen, viele vielleicht nicht, denn das Spektrum der empirischen Phänomene im Verlaufe von ca. 3.5 Mrd. Jahre ist so unfassbar groß, dass es im Einzelfall eine Komplexität vieler Details gibt, die das zugrunde liegende ‚Prinzip‘ des Lebendigen verdecken kann. Die Formulierung ‚Selbstorganisation der Materie‘ stellt auch eine Verbindung her zur Perspektive des ganzen Universums und zur Thematik der Kosmologie (auch ein Aspekt beim späten Popper).

Bei der Kulturanthropologie folge ich einer Idee von Popper, der am Beispiel der massiven Veränderungen von Kultur durch aktuell verfügbare ‚Techniken‘ (Landwirtschaft, Rohstoffe, Bauten, Maschinen,…) den Gedanken nahelegt, dass ‚Kultur‘ vielleicht verstehbar ist als die Summe der Handlungsweisen von Menschen zu einer bestimmten Zeit an einem bestimmten Ort, die sich ‚ganz natürlich‘ den realen Gegebenheiten ‚anpassen‘, einfach durch das ‚faktische Tun‘. Man muss Essen. Und dazu benutzt man bestimmte Nahrungsmittel, bereitet sie zu, hat bestimmte Essrituale, und wenn sich die Nahrungsmittel ändern, die Küchengeräte, … dann ändert sich das Verhalten. In der digitalisierten Welt von heute haben sich unzählig viele Verhaltensweisen geändert, einfach weil man es heute ‚anders macht‘ als früher, weil man ‚real andere Möglichkeiten‘ hat. Technologie ist insofern ein ‚Medium‘ für Kultur. Der ‚Geist‘ erschafft zwar Technologie, aber als realer Teil des Alltags verändert dann die Technologie den Geist.

Die Soziologie beschäftigt sich vielfach einfach mit ‚Handlungsnetzwerken‘: die handelnden Akteure stehen in kontinuierlicher Wechselwirkung miteinander, wirken aufeinander ein, und da die ‚äußeren Ereignisse‘ sich über Körper und Gehirn in ‚innere Ereignisse‘ transformieren, können die Außenereignisse auch ‚im Innern‘ vielfältige Wirkungen entfalten. Die Vielfalt der Faktoren, die sowohl ‚im Innern‘ wie ‚im Außen‘ wirksam sein können ist nahezu unerschöpflich. Mögliche Einschränkungen kommen aus der realen Beschaffenheit der Körperwelt und der biologischen Beschaffenheit eines Homo sapiens.

Eine mögliche Aufgabenstellung von Politikwissenschaft könnte die Untersuchungen des Konzepts von ‚Macht‘ sein, wie es unter und zwischen Menschen auftreten kann, und wie man es so gemeinschaftlich gestalten kann, dass eine möglichst optimale Wirkung für möglichst viele ermöglicht wird.

Im Fall der angewandten Informatik ist die Sachlage einerseits einfach, weil es von der theoretischen Informatik klar definierte Konzepte zu vielem gibt, wie z.B. ‚Berechenbarkeit‘, ‚Automat‘, ‚Formale Sprache‘, ‚Befehlsliste = Programm = Algorithmus‘, ‚Komplexität‘, …) , wobei das Konzept der ‚Berechenbarkeit‘ das fundamentale ist. Die praktische Umsetzung allerdings kann in unendlich viele Varianten zersplittern, was ja die heutigen praktischen Anwendungen mittels Computern und Computernetzwerken demonstrieren. [5] In der letzten Zeit ist zu beobachten, dass durch die immer dichtere Vernetzung von Informatik-Prozessen und -Geräten mit nahezu jedem Aspekt des Alltagslebens das Interaktionsverhältnis zwischen Menschen und Computertechnologien das Mensch-Maschine Interaktionsverhältnis immer mehr in den Fokus der Aufmerksamkeit rückt. Mit dem Menschen dann letztlich die ganze Gesellschaft. Spätestens an dieser Stelle sollte klar werden, dass diese Technologie Teil der ‚Kultur‘ geworden ist und damit zu einem genuinen Gegenstand auch der Kulturanthropologie, sicher auch der Soziologie und der Politikwissenschaft.

Meta-Wissenschaften

Natürlich kann man hier viele Fragen ‚über‘ (‚meta‘) diese genannten Disziplinen stellen. Diese Fragen führen dann zu einer Art von Wissenschaft, deren Gegenstände entweder ‚wissenschaftliche Disziplinen‘ sind oder ‚abstrakte Strukturen‘, die sich hinter Bezeichnungen verbergen wie “Logik‘, ‚Mathematik‘ oder ‚Theoretische Informatik‘. Ein maximal abstrakter Gegenstandsbereich ist wohl das ‚Wissen um das Wissens‘, was ansatzweise beschreibt, was ‚Philosophie‘ machen kann.

Eine heute immer drängendere Aufgabenstellung in diesem Bereich ist die Herausforderung, den ‚Zusammenhang zwischen den Einzelwissenschaften‘ so herstellen zu können, dass die unterschiedlichen Erkenntnisse nicht — wie aktuell weitgehend — nur isoliert zur Verfügung stehen, sondern dass die unterschiedlichen ‚wissenschaftlichen Kompartments‘ in einer ‚transdisziplinären‘ Weise aufeinander beziehbar werden.

Traditionellerweise war dies die Aufgabenstellung der Wissenschaftsphilosophie. Doch kann man nicht behaupten, dass diese Aufgabe irgendwie eingelöst sei. Dazu müssten auch die Einzeldisziplinen dies wollen. Diese scheinen aber bislang mit ihrem ‚Inseldasein‘ ganz zufrieden zu sein.

Menschenbilder

Jede der genannten empirischen Disziplinen beschäftigt sich ‚irgendwie‘ auch mit solchen Akteuren, die der Lebensform des Homo sapiens zuzurechnen sind. Wie man leicht feststellen kann, ist das Bild eines ‚Menschen‘ in den Einzelwissenschaften — sofern es überhaupt offiziell definiert wird — sehr unterschiedlich. In vielen Zusammenhängen kommen Menschen zudem gar nicht oder nur sehr beiläufig vor. Obgleich es Menschen sind, die diese Wissenschaften betreiben und entwickeln, kommen sie selbst als die zentralen Akteure im offiziellen Bild der Wissenschaft mehr oder weniger nicht vor. Dies bedeutet, zentrale dynamische Faktoren des Wirklichkeitsprozesses werden in den jeweiligen wissenschaftlichen Bildern mehr oder weniger ausgeklammert. Es wäre mal interessant, für jede Disziplin heraus zu arbeiten, welches Menschenbild sie unterstellen, und wie diese Menschenbilder mit den wichtigen theoretischen Konzepten interagieren.

Diskurs

Ein Aspekt des Menschenbildes, der eigentliche alle wissenschaftlichen Disziplinen betrifft, ist der Aspekt der menschlichen Kommunikation als das zentrale Medium, durch das sich die verschiedenen Gehirne koordinieren. Ohne diese Kommunikation ist Wissenschaft unmöglich. Tatsächlich werden unzählig viele Texte publiziert. Ein Text ist aber nur dann eine Botschaft, wenn der Text eine Sprache benutzt, welche die beteiligten Gehirne in dem Sinne ‚kennen‘, dass der Bezug zu einer ‚gemeinten‘ Bedeutung hergestellt werden kann und dann über diese Bedeutung zu einer ‚aufzeigbaren Ereigniswelt‘. Dies sind alles keine trivialen Prozesse. Im Alltag misslingen sie vielfach, vielleicht zu oft, und komplexe Projekte scheitern in der Regel am Misslingen dieser Kommunikation.

Sowohl für die Wissenschaft wie auch für die Alltagswelt ist es also keineswegs unwichtig, wie ein Diskurs gestaltet werden sollte, damit möglichst viele möglichst viele komplexe Inhalte gemeinsam verstehen können. Die zu frühe ‚Delegation‘ dieser Verstehensaufgabe an ‚Maschinen‘ — sprich Computer — ist keine Lösung.

Oksimo Diskursraum

Der ‚oksimo Diskursraum‘ wird so genannt, weil es eine Software mit Namen ‚oksimo (reloaded)'[4] gibt, deren Benutzung darin besteht, dass man eine bestimmte Form eines Diskursraumes zur Verfügung gestellt bekommt. Beliebige Akteure einer Population können mit ihrer Alltagssprache ihre Situation, ihre Welt so beschreiben, wie sie glauben, dass diese Welt beschaffen sei. Zu dieser ‚Ausgangslage‚ können sie dann ‚Ziele‚ formulieren, welche zusätzlichen oder gänzlich neuen Eigenschaften sie für ihre Welt in der Zukunft erreichen wollen. Im Hinschreiben sind alle Teilnehmer gleichberechtigt. Keiner kann dem anderen vorschreiben, was er für sich hinschreiben will. Dann besteht die Aufgabe für alle darin, ‚Maßnahmen‚ zu finden, mit denen man die Ausgangslage schrittweise so umgestalten kann, dass nach und nach der Zielzustand erreicht wird. Das Besondere bei der Beschreibung der Ausgangslage und der Maßnahmen ist, dass die Autoren beliebige Akteure in die Beschreibung einbeziehen können, also auch das Verhalten von Menschen oder auch von quasi autonomen Algorithmen, Maschinen, was auch immer in der Welt vorkommen kann. Will man zwischendurch wissen, wie gut die bisherige Beschreibung ist,dann kann der eingebaute Simulator jederzeit auf Wunsch zeigen, wie weit man mit den bislang formulierten Maßnahmen kommt. Damit entsteht ein Moment der Selbstreflexion, eine Form von ‚Meta-Theorie‘. ‚Über sich selbst‘ nachdenken oder sich von anderen Feedback einholen.

Was hier auf den ersten Blick aussieht, als ob man zusammen eine ‚Geschichte erzählt‘, eine ‚Story‘, in Form eines ‚Drehbuchs‘, hat aber noch eine ganz andere Qualität. Der oksimo Diskursraum produziert ‚automatisch‘ eine vollständige empirische Theorie inklusive Folgerungsbegriff und der Ableitung von Prognosen.

Dieser letzte Punkt soll in einem eigenen Post ausführlich behandelt werden. Darin wird dann auch speziell darauf eingegangen, ob und wie die Anforderungen von Popper an eine empirische Theorie erfüllt werden. Hier sei nur so viel vorweg gesagt: der oksimo Diskursraum ist vollständig ‚Popper Kompatibel‘ 🙂

Anmerkungen

[1] Karl Popper, „A World of Propensities“,(1988) sowie „Towards an Evolutionary Theory of Knowledge“, (1989) in: Karl Popper, „A World of Propensities“, Thoemmes Press, Bristol, (1990, repr. 1995)

[2] Karl Popper, „All Life is Problem Solving“, Artikel, ursprünglich ein Vortrag 1991 auf Deutsch, erstmalig publiziert in dem Buch (auf Deutsch) „Alles Leben ist Problemlösen“ (1994), dann in dem Buch (auf Englisch) „All Life is Problem Solving“, 1999, Routledge, Taylor & Francis Group, London – New York

[3] Viele Anregungen habe ich heute dazu auch von Athene Sorokowski und Philipp Westermeier empfangen, als wir in einer Sitzung am 22.2.2022 über ähnliche Themen diskutierten. Von Philipp Westermeier ist mir u.a. der Aspekt der ‚Macht‘ bewusster geworden, ohne dass ich dieses Phänomen bislang hinreichend ‚verstehe‘. Von Athene Sorokowski kam u.a. der Aspekt, dass viele Einzeldisziplinen sich im Fall ihres Selbstverständnisses de facto um relativ abstrakte Begriffe gruppieren, ohne einen klaren Ereignisbezug zu haben.

[4] Einige Informationen zur oksimo Software und dem oksimo Paradigma finden sich hier: https://www.oksimo.org/

[5] Die Redewendung vom ‚Digitalen‘ im Zusammenhang mit berechenbaren Prozesse mittels Computern ist eigentlich völlig irreführend. Für die materielle Umsetzung berechenbarer Prozesse spielt es zwar eine wichtige Rolle, dass man in Form von ‚digitalen Chips‘ ein Material gefunden hat, das sich für die Umsetzung des Konzepts wunderbar eignet, aber ob ein Computer-Programm digital kodiert wird, oktal, hexadezimal oder wie auch immer, ist unwesentlich. Im übrigen sei darauf hingewiesen dass die Nervenzellen im Gehirn für die eigentliche Signalverarbeitung auch ‚digital‘ arbeiten, obgleich jede einzelne Zelle selbst ein hochkomplexes bio-chemisches Wunderwerk darstellt. Auch in einem ‚Chip‘ sind die tatsächlichen Signale nicht ‚binär‘ sondern analog. Die ‚Binarität entsteht dadurch, dass der analoge Spannungsraum künstliche in ‚Zonen‘ unterteilt wird, so dass eine Zone mit ‚hoher Spannung‘ als ‚1‘ interpretiert wird und eine Zone mit niedriger Spannung mit ‚0‘. Das ‚Binäre ist also ein ‚Artefakt‘, das aufgrund eines theoretischen Konzepts in die ‚analoge Materie‘ hineinprojiziert wird.

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.

Fortsetzung

der Diskussion um Popper HIER.