— Dieser Text ist keine 1-zu-1 Wiedergabe des Live-Vortrages. Er wird noch weiter ergänzt werden, da das Thema für den Autor auch unabhängig von dem Vortrag wichtig ist —

Journal: Philosophie Jetzt – Menschenbild

ISSN 2365-5062, 12.-18.Januar 2021

URL: cognitiveagent.org, Email: info@cognitiveagent.org

Autor: Gerd Doeben-Henisch (gerd@doeben-henisch.de)

KONTEXT

Dieser Text ist die schriftliche Fassung eines Vortrags, den ich am 12.Januar 2021 17:00 – 19:30h im Rahmen einer Vortragsreihe von Studierenden der Universität Leipzig gehalten habe. Ich persönlich halte es für wichtig, Initiativen von Studierenden zu unterstützen. Der volle Titel des Vortrags lautet:

INGENIEURE UND DAS GLÜCK

Wie können Ingenieure im Rahmen der Disziplin

Mensch-Maschine-Interaktion dazu beitragen, die Möglichkeiten der

Technik für ein gutes, glückliches Leben der Menschen zu nutzen?

(Der Video-Mitschnitt dieses Vortrags findet sich HIER. Achtung: mehr als 2 Stunden! In der Musik würde man von einem ‚unplugged‘ Vortrag sprechen :-))

POSITION DES AUTORS

Jeder Zuhörer — und dann auch vielleicht Leser — dieses Vortrags mag sich spontan fragen, was den Autor dazu antreibt, über ein Thema wie Ingenieure und das Glück zu sprechen? Zumal der Autor — wie aus den beiden Blogs cognitiveagent.org [DE] und uffmm.org [DE] ersichtlich — nicht dem klassischen Bild des Ingenieurs entspricht. [1] Er begann als Theologe und klassisches Philosoph, migrierte zur Wissenschaftsphilosophie und promovierte mit einem Thema zur Beweistheorie (Teil der formalen Logik). Er war dann jahrelang wissenschaftlich tätig im Bereich Kognitionswissenschaft und ist seit 2002 Professor für Informatik. Neben unterschiedlichen Disziplinen waren seine Hauptgebiete Mensch-Maschine Interaktion [HMI], Künstliche Intelligenz [KI] und Simulation. Nach seiner Emeritierung arbeitet er — neben einzelnen Lehrveranstaltungen — noch weiter an wissenschaftsphilosophischen Themen und an einer Theorie des Integrierten Engineering mit den Teilaspekten Human-Maschine Intelligence [HMInt] als Teilaspekt des Themas Human-Machine Interaction [HMI]. Hier entwickelt er auch seit September 2020 (zusammen mit Tobias Schmitt) eine neue Software, die die Umsetzung dieser Theorien im Alltag unterstützen soll.

Die meisten Zuhörer — oder Leser — dieses Beitrags werden sich vermutlich fragen, was hat ausgerechnet ein Ingenieur mit dem Thema Glück zu tun? Einen Ingenieur assoziiert man eher mit dem Thema Technik und Technik gilt für viele nicht als besonders ‚Glück affin‘.

Es ist das Ziel dieses Beitrags, sichtbar zu machen, dass Ingenieure sehr wohl etwas mit dem Thema Glück zu tun haben, vielleicht sogar viel mehr als die meisten, die für sich in Anspruch nehmen, Experten*innen für das Thema Glück zu sein.

DAS WORT GLÜCK

Das Wort Glück ist vermutlich das viel-schillerndste Wort, was wir in der deutschen Sprache haben.[2] Und ein kurzer Blick in den Alltag und die Geschichte zeigt, dass man im Zusammenhang mit dem Begriff Glück nicht gerade alles finden kann, was es gibt, aber doch so Vieles und Unterschiedliches, dass man vorsichtig sein sollte, zu schnell mit einer einfachen Definition zur Hand zu sein.

…IN DER GESCHICHTE

Das Thema Glück gibt es — traut man den vielfältigen Zeugnissen — solange es Menschen gibt, die davon auf irgend eine Weise Zeugnis abgelegt haben. Wir können die großen Mythen durchwandern, Kunst allgemein, Theater und Literatur speziell, kulturelle Großereignisse, die europäische und indische Philosophie, Spiritualität und Mystik …. heute auch moderne Erzählformen wie Comics, Filme, Computerspiele, die von hunderten von Millionen Menschen konsumiert werden. Die Vielzahl an Ansichten, Sichten, Formen, Szenarien ist überwältigend. Wenn wir spielerisch die Ansicht des Aristoteles in seiner Schrift Hermeneia folgen [15], dann sind die vielfältigen Zeugnisse Ausdruck der Seele des Menschen, das, was sie innerlich betrifft, beschäftigt. Und wir tun wahrscheinlich gut daran, zuzuhören, zuzusehen, wie sich die Seele des Menschen, sein Inneres in diesem anschwellenden Strom der Zeiten ausdrückt.

… IM ALLTAG

Im eigenen Alltag wirkt alles oft viel banaler; die Aura des besonderen Ausdrucks, die künstlerisch veranlagten Menschen eigen ist, ist im Alltag eher stumm; und doch sind es immer noch wir Menschen, die da handeln und erleben.

Körperliche Bedürfnisse die beunruhigen und quälen können, kennt wohl jeder, auch das angenehme Gefühl, wenn man bei Durst, Hunger, Schlaflosigkeit usw. entsprechende Entspannung beim Trinken, Essen oder im Schlafen finden kann.

Es gibt aber auch Gefühle wie Angst, Wut, Enttäuschung, Hoffnung, denen unterschiedliche Ereignisse korrespondieren können: Angst kann man vor Tieren, Menschen, Situationen oder einfach Gegenständen haben. Wut kann sich gegen einen selbst richten, gegen andere, gegen die Verhältnisse schlechthin, … Enttäuschungen können Kinder empfinden, Erwachsene, Ältere bei nahezu unendlich vielen Dingen. Enttäuschungen gehen meist Hoffnungen, Erwartungen voraus. usw.

Ein Sammler von Uhren freut sich über eine seltene Uhr, ein Briefmarkensammler nicht. Ein Fußballfan lebt mit seiner Mannschaft, der Fan eines Sängers, einer Sängerin nicht. Er/Sie leidet mit den Ereignissen um das Idol.

Die Anhänger einer bestimmten politischen Richtung können furchtbar enttäuscht werden, wenn bei einer Wahl die andere politische Richtung gewinnt; es kann zu Aggressionen und Ausschreitungen kommen. Der Anhänger einer bestimmten religiösen Glaubensrichtung kann für seinen Glauben leiden, dienen, aber auch Glücksmomente erleben, selbst bei Verfolgung und Tod; Berichte von Märtyrern gibt es genug.

Es gibt Menschen, die leiden grundsätzlich an ihrer Situation (klischeehaft: die Pessimisten), andere (klischeehaft: die Optimisten) sehen überall Chancen und partielles Glück. Als junger Theologiestudent konnte ich im Rahmen eines Praktikums mal 6 Monate lang kranke Menschen über 65 in einem bestimmten Stadtteil in einer großen Deutschen Stadt besuchen. Eine Erfahrung hat mich damals sehr beeindruckt: es gab Menschen, die nicht unbedingt sehr krank waren, diese Menschen hatten aber eine dermaßen nieder ziehende Wirkung auf meine Gefühle, dass ich danach stundenlang ziemlich fertig war. Dann gab es andere Menschen, die tatsächlich schwer krank waren, bisweilen todkrank, die hatten aber eine Ausstrahlung, dass ich mich anschließend fast glücklich fühlte. Vielleicht haben Sie dies in ihrem Leben auch schon Ähnliches erlebt. Wir Menschen können für andere Quelle von guten Gefühlen sein, von Glücksgefühlen, oder auch das Gegenteil.

Dann gibt es dort die alten Bilder von Menschen die Macht und Reichtum anhäufen und zugleich alles andere als glücklich erscheinen, und jene, die fast nichts zu haben scheinen, und doch glücklich zu sein scheinen. Gewiss, dies ist eine gefährliche Metapher dann, wenn sie dazu benutzt wird, die Existenz von Armut zu rechtfertigen, aber hier, in diesem Kontext geht es zunächst einmal darum festzuhalten, dass das Vorhandensein von äußeren Gegebenheiten nicht notwendigerweise Glück garantieren muss.

Die einen lieben das Meer, andere die Berge. Die einen suchen das Land jenseits der Städte, andere wollen unbedingt in die Stadt. Die einen … die anderen …

In all diesen Alltagsfragmenten deutet sich an, dass wir in der Regel mindestens zwei Komponenten haben: (i) auf der einen Seite innere Gefühlszustände eines Menschen und (ii) sehr oft, vielleicht meistens auch, äußere Gegebenheiten, die irgendwie als zusammenhängend mit den inneren Zuständen gesehen werden.

Gibt es in dieser Alltags-Weltlichen Vielfalt irgendwelche Koordinaten, einer allgemeineren Struktur? Was können hier die Ingenieure leisten?

INGENIEURE

Mein Heimatfachbereich an der Frankfurt University of Applied Sciences [FUAS] [4] war der Fachbereich 2 für Informatik und Ingenieurwissenschaften.[5] Obgleich sich hier schon viele Themen aus dem Bereich Informatik und Ingenieurswissenschaften finden [6] ist dies nur ein winziger Ausschnitt aus dem schier unfassbaren großem Spektrum an Themen, die Ingenieure heute bearbeiten. Und wenn wir jetzt gemeinsam anfangen würden, unsere alltägliche Lebenswelt durchzumustern, dann würden wir feststellen, dass es fast nichts gibt, wo nicht irgendwelche Ingenieure ihre Hand mit ihm Spiel haben. Dabei sind viele Produkte oder Verfahren gar nicht mal direkt sichtbar, da sie sich hinter alltäglich gewohnten Oberflächen verbergen.

Wenn uns auch hier, im Fall der Ingenieure, eine solche Vielfalt wie beim Phänomen Glück begegnet, kommen wir hier dann nicht buchstäblich ‚vom Regen in die Traufe‘, wie ein altes Sprichwort sagt: tauschen wir also das Universum der alltäglich möglichen Glücksphänomene auf Seiten der Ingenieure nur ein mit einem neuen Universum von möglichen Produkten, Verfahren und Dienstleistungen ohne eine klare erkennbare Struktur zu finden, die irgendwelchen Halt für Erkenntnisse geben könnte?

Offen ist auch noch die Frage, wie wir Ingenieure abgrenzen können oder gare müssen gegenüber Wissenschaftlern, gegenüber Philosophen oder gar gegenüber Künstlern? Kann man sie überhaupt abgrenzen?

DER FAKTOR MENSCH: HCI, HMI

Ein erster Anhaltspunkt für den weiteren Gedankengang bietet der Untertitel meines Vortrags der da lautet: Wie können Ingenieure im Rahmen der Disziplin Mensch-Maschine-Interaktion dazu beitragen, die Möglichkeiten der Technik für ein gutes, glückliches Leben der Menschen zu nutzen?

Alle Ingenieurtätigkeiten fallen unter ein großes Thema: Wie komme ich von einem gestellten Problem zu dessen Lösung? Das zentrale Werkzeug jeder Ingenieurlösung ist zuallererst der Ingenieur selbst! Sein Wissen, seine Erfahrungen, seine Emotionen, seine Sprachfähigkeit usw. bilden das Medium, das seine Kommunikation mit anderen ermöglicht, gemeinsame Analysen, Planungen und Implementierungen. Ohne Ingenieure passiert gar nichts. Richtig ist natürlich auch, dass der beste Ingenieur nichts nützt, wenn es keine passende Umgebung gibt. Der Biologe und Philosoph von Uexküll hatte 1909 das Konzept der komplementären Umgebung zu einem biologischen System eingeführt [7][7b], und dies gilt für alle biologischen System, auch für den homo sapiens, auch für solche Menschen, die über spezielle Fähigkeiten verfügen wie z.B. für einen Ingenieur. Ein erfahrener Ingenieur kann in der richtigen Umgebung in 20 – 30 Jahren so viel Erfahrungen, so viel Wissen, so viele Fähigkeiten erwerben, dass er — falls er in einer geeigneten Umgebung lebt –, damit großartige Dinge erschaffen kann, noch mehr in Zusammenarbeit mit anderen, wenn diese Zusammenarbeit funktioniert.

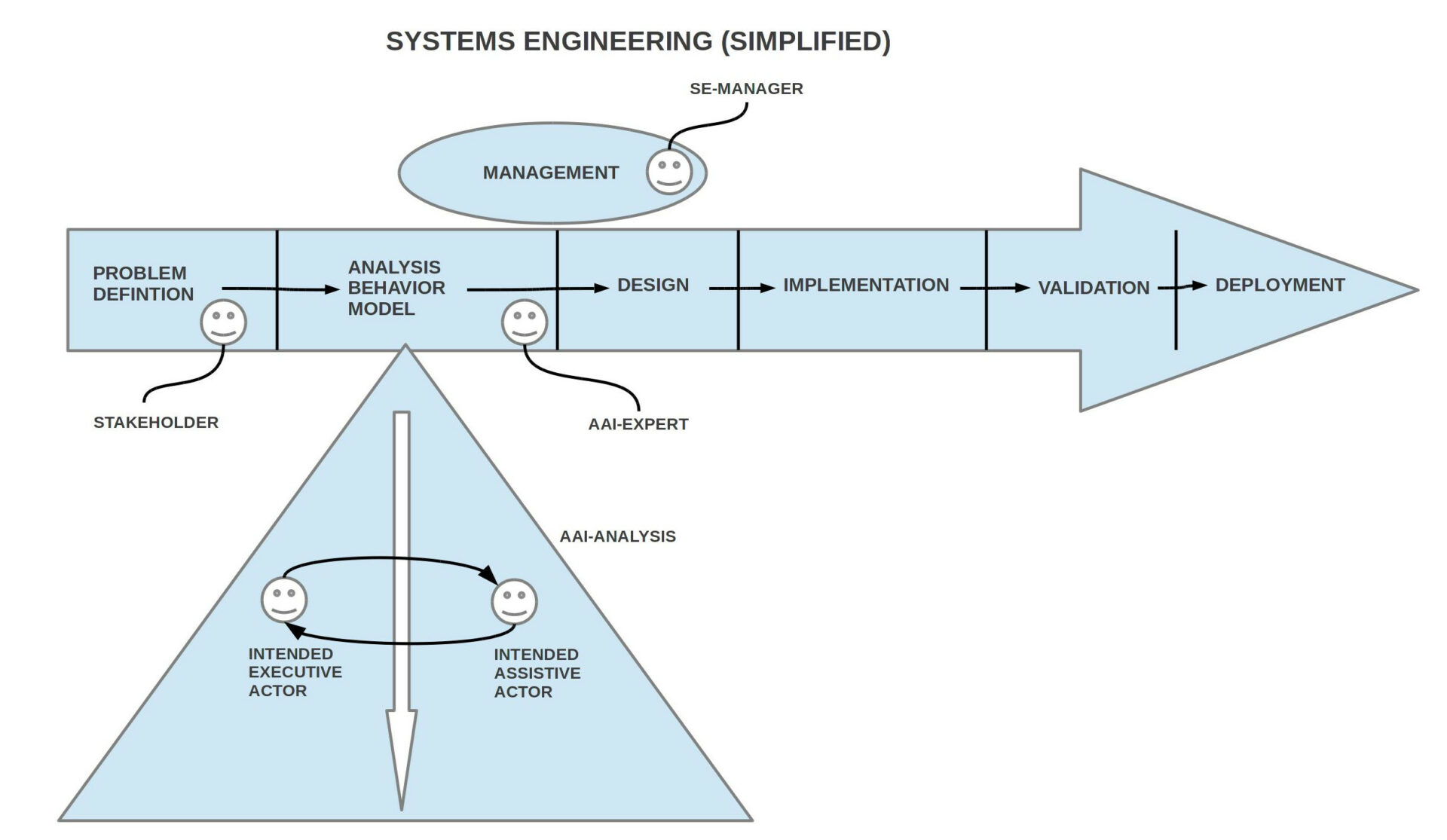

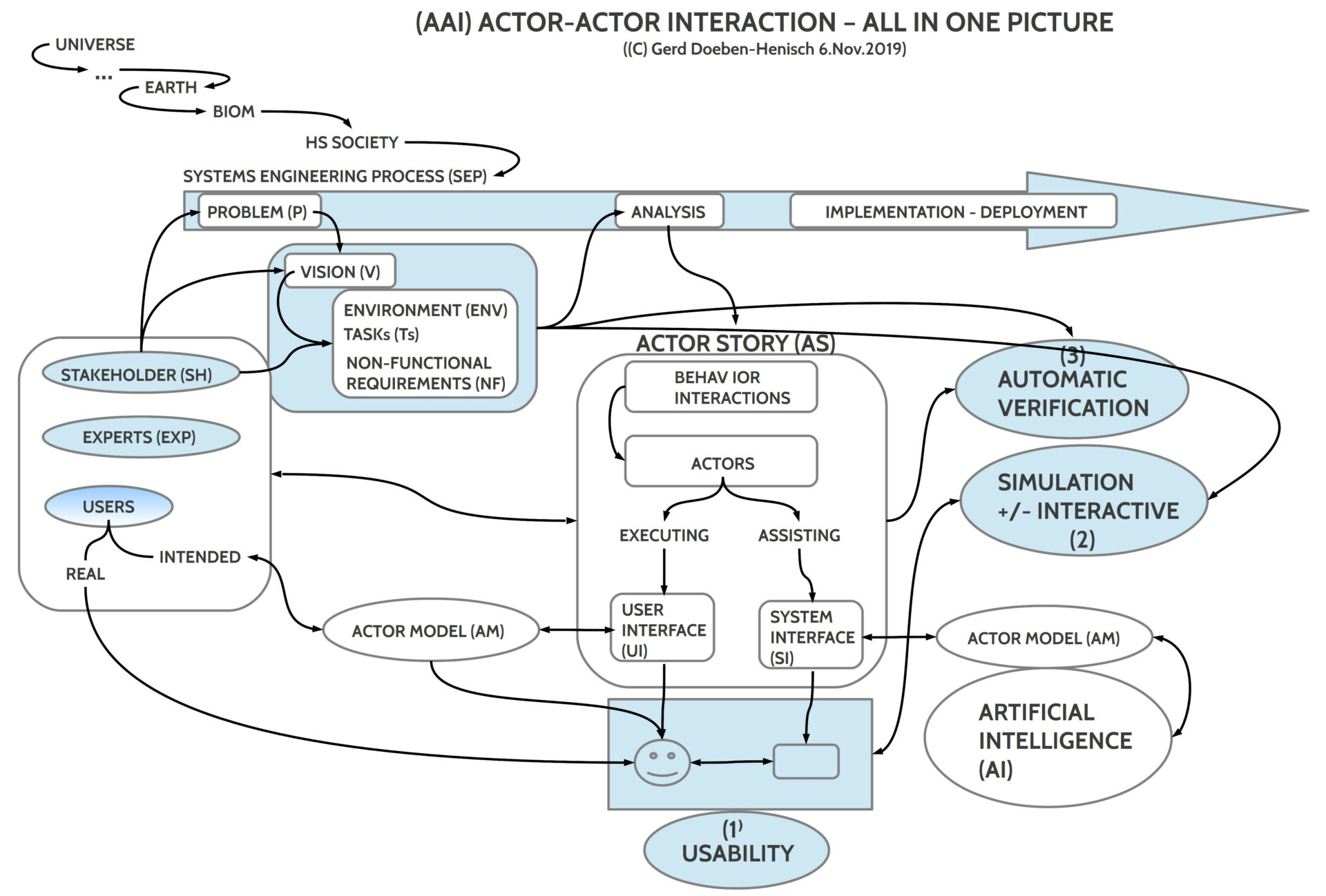

Es verwundert jetzt vielleicht nicht, wenn ich sage, dass die Ingenieure seit ca. 80 Jahren begonnen haben, die Gesamtheit ihres Wissens zum Problemlösen zu systematisieren. Die Überschrift über diese Aktivitäten lautet Systems Engineering.[8], [8b], [10] Ein stark vereinfachtes Schema des Systems Engineering Prozesses zeigt das folgende Schaubild.

Während das Bild den Eindruck erweckt, dass der Weg vom Problem zur Lösung linear verläuft, sind aber alle Prozesse stark repetitiv, zyklisch, iterativ. Dies liegt daran, dass komplexe Problemstellungen sich nicht sofort auf einen Schlag analysieren und synthetisieren lassen. In der Regel erfolgt eine approximierende Analyse vom Einfachen zum Komplexen.

Während das Thema Handhabung von Werkzeugen/ Maschinen/ Verfahren schon immer ein Thema war verbunden mit entsprechenden Schulungen, führte die Einführung des Computers ab ca. 1945 dazu, sich verstärkt Gedanken über den benutzenden Menschen zu machen. Und je mehr der Computer als Gerät in den vielfältigen Alltag mit seinen bisweilen komplexen Verhaltensabläufen vordrang, um so mehr wurde plötzlich der Mensch als Benutzer/ Anwender (‚user‘) zu einem eigenständigen Thema. Die Disziplin Human-Computer Interaction [HCI] oder auch Human-Machine Interaction [HMI] war geboren.[9], [9b], [9c]

Während die Disziplin HMI/ HCI nicht notwendigerweise als Teil des Systems Engineerings behandelt werden muss, spricht vieles dafür, es so zu handhaben. Ich selbst habe dies Strategie von ca. 2005 bis 2018 verfolgt.[10]

Das folgende Schaubild lässt ein wenig erkennen, was es heißt, dass der Mensch immer mehr in den Fokus der planenden Ingenieure gerät:

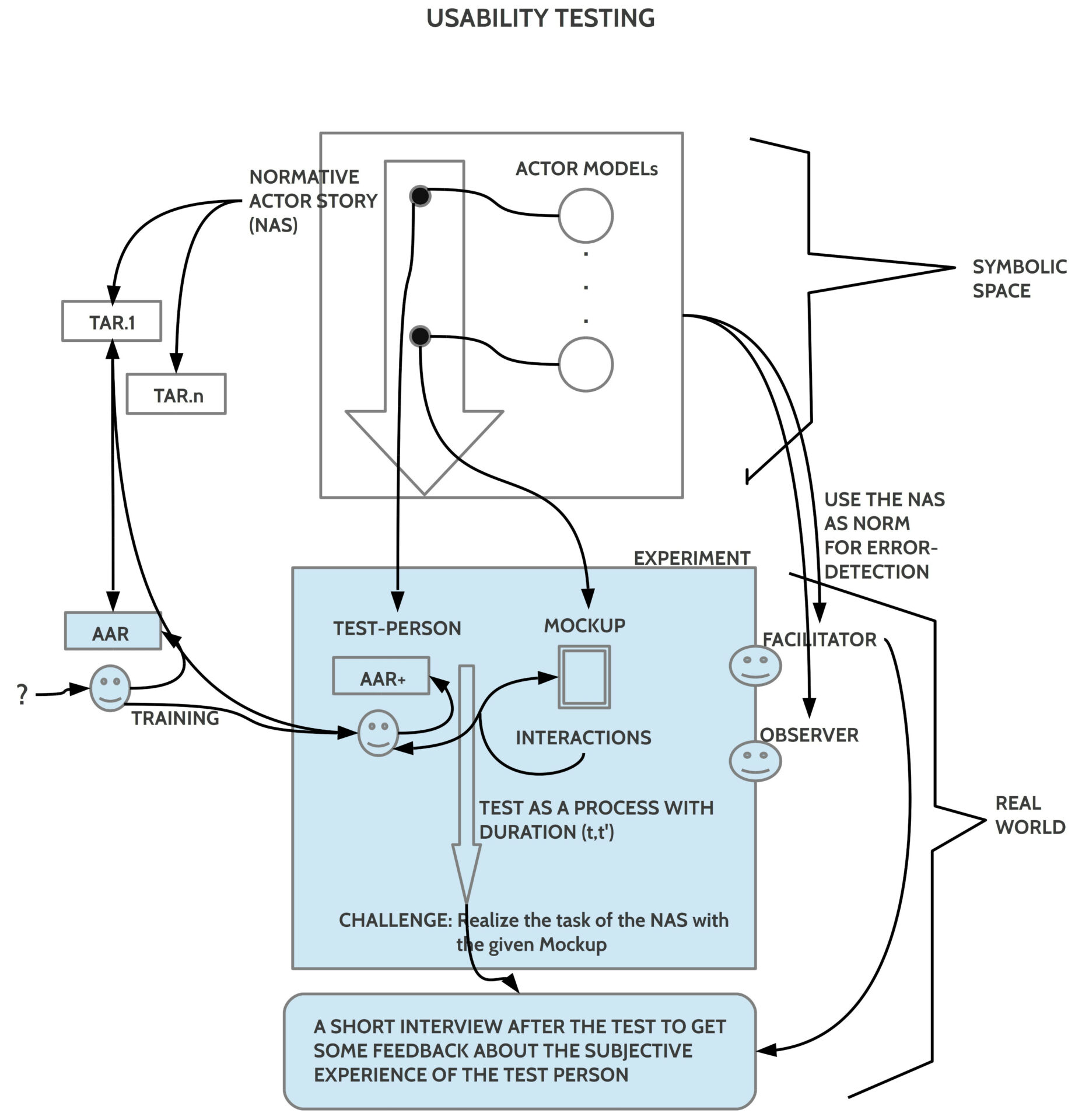

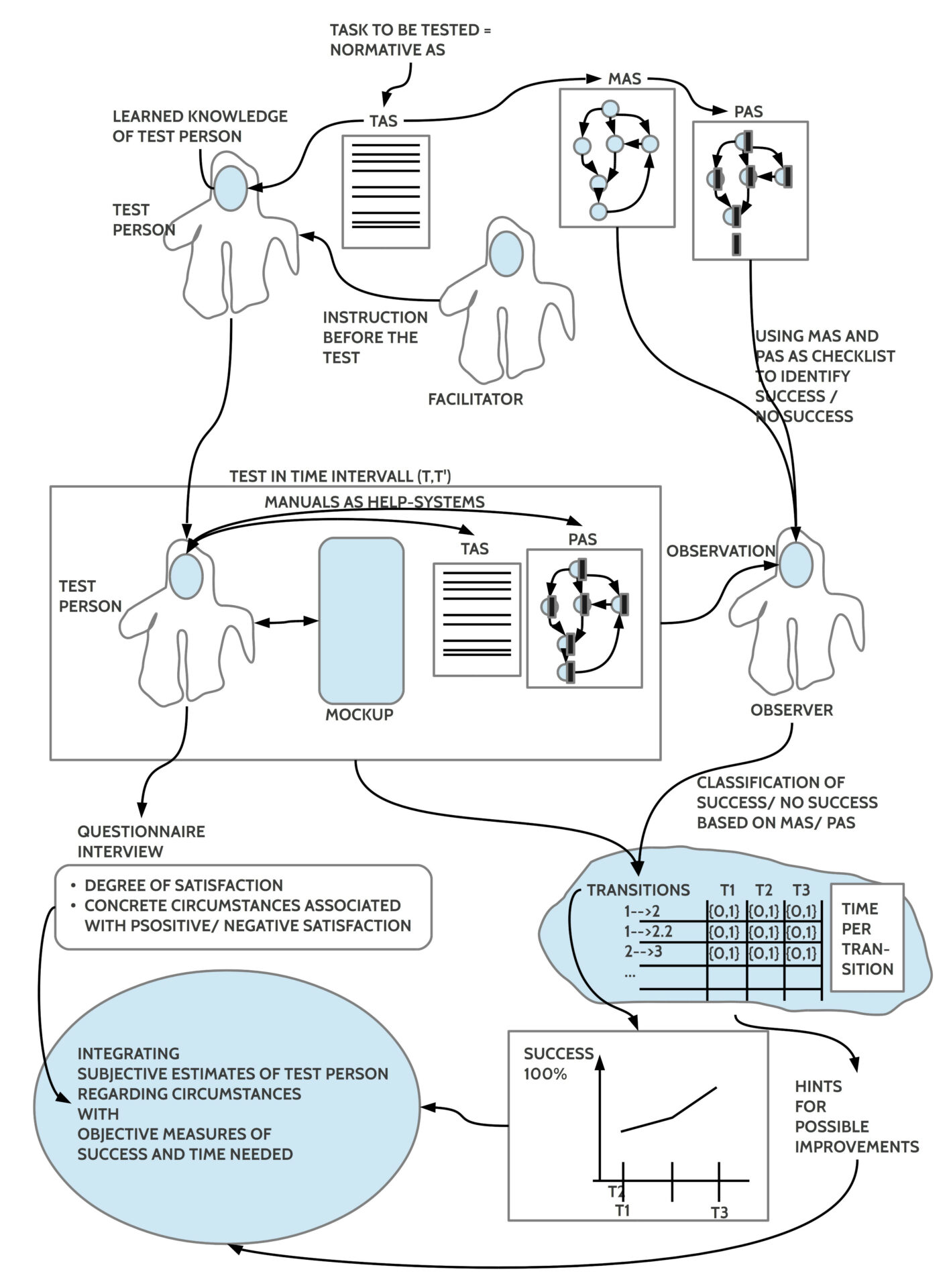

USABILITY – BENUTZBARKEIT – IMPLIZITE WERTE

Was immer Ingenieure entwickeln, sie müssen es soweit testen/ evaluieren/ bewerten, dass aus diesem Bewerten hervorgeht, ob das Ziel der Problemstellung erreicht wurde oder nicht. Dabei bezieht sich der Ingenieur auf zwei unterschiedliche Kriterienkataloge: (i) jene, die sich aus der Actor Story als konkrete Anforderungen ergeben, und (ii) jene, die sich aus gesellschaftlichen Vorgaben ergeben. Um die Anforderungen zu testen, die sich aus der Actor Story ergeben, müssen diese symbolischen Beschreibungen der intendierten Akteure und ihrer Handlungen in der realen Welt mittels realer Mock-ups und realer Testpersonen quasi nachgestellt werden. Im Rahmen eines Benutzbarkeitstests (usability test) versuchen Testpersonen unter Aufsicht eines Versuchsleiters (facilitator) und unter den Augen von zusätzlichen Beobachtern (observer) Aufgaben aus der Actor Story auszuführen. Abweichungen von der Actor Story gelten als Fehler.

In den meisten Fällen wird heute immer nur ein Test gemacht und berichtet. Der Mensch ist aber grundlegend lernfähig. Stößt ein Mensch auf ein Problem, macht er einen Fehler, dann wird er diesen Fehler beim nächsten Mal normalerweise nicht mehr machen oder zumindest nach wenigen Wiederholungen nicht mehr. Und da anspruchsvolle, komplexe Systeme viele Aspekte umfassen, können diese normalerweise nicht durch einen einzigen Durchlauf gelernt werden; es bedarf vieler Lerndurchläufe. Bei einem Usability-Test geht es also nicht darum, ob eine bestimmte Person ein bestimmtes System einmal testet, sondern die interessante Frage ist die Folgende: (i) Lässt sich die Benutzung eines Systems überhaupt lernen und wie schnell? (ii) Wie lernfähig ist eine bestimmte Person? Das beste System nützt nichts, wenn der Anwender eine zu geringe Lernfähigkeit aufweist, und umgekehrt, die beste Lernfähigkeit auf Seiten des Anwenders nützt nichts, wenn das System einfach zu unübersichtlich, zu komplex ist, bis man es erlernen kann. Für diesen dynamischen Charakter des Actor-Actor Interaction (Mensch-Maschine, HCI/HMI) Paradigmas gibt es bislang so gut wie keine Standards (außer dem, was Psychologen standardmäßig in ihren Lern-Experimenten machen)

BENUTZBARKEIT UND GESELLSCHAFT

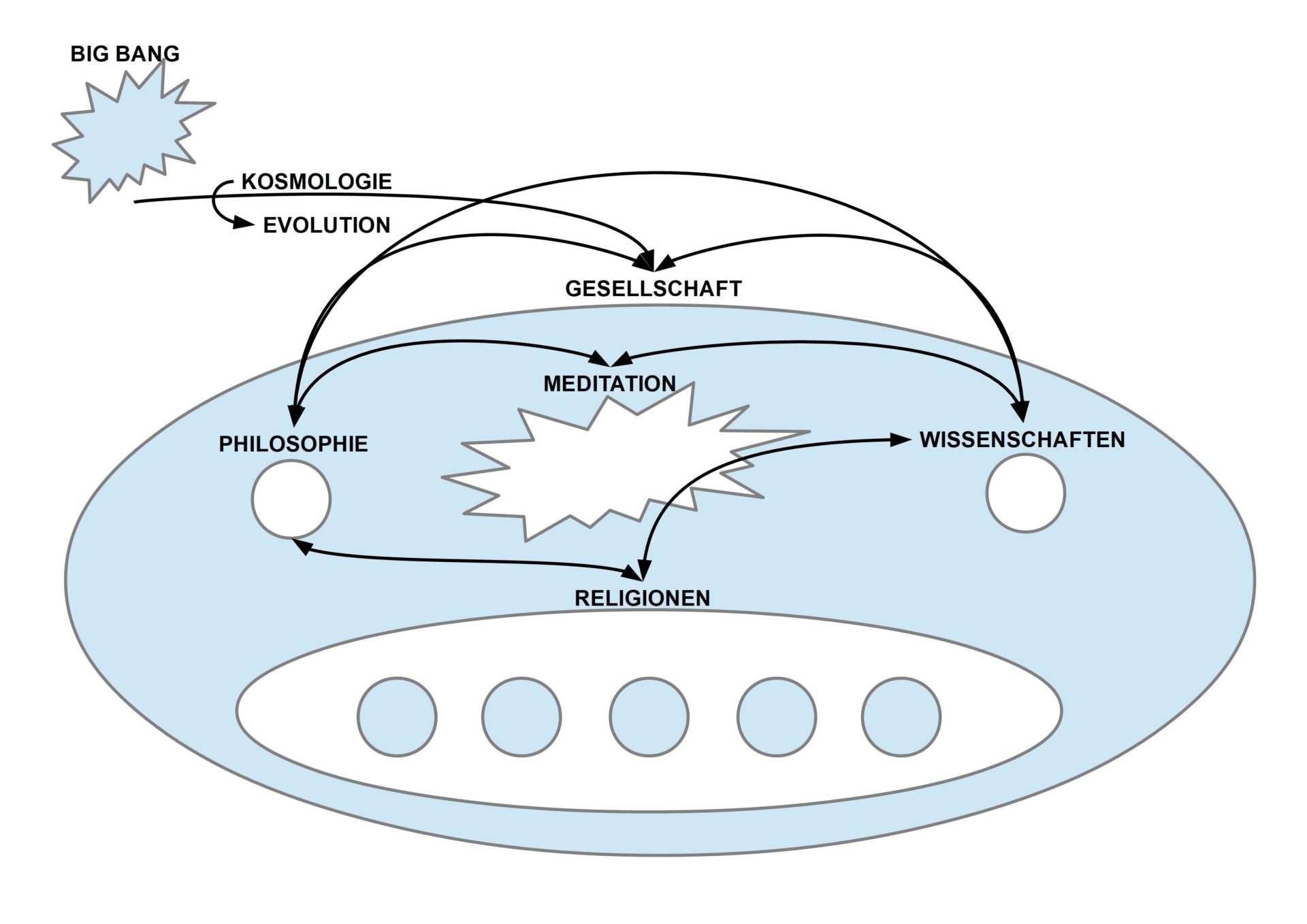

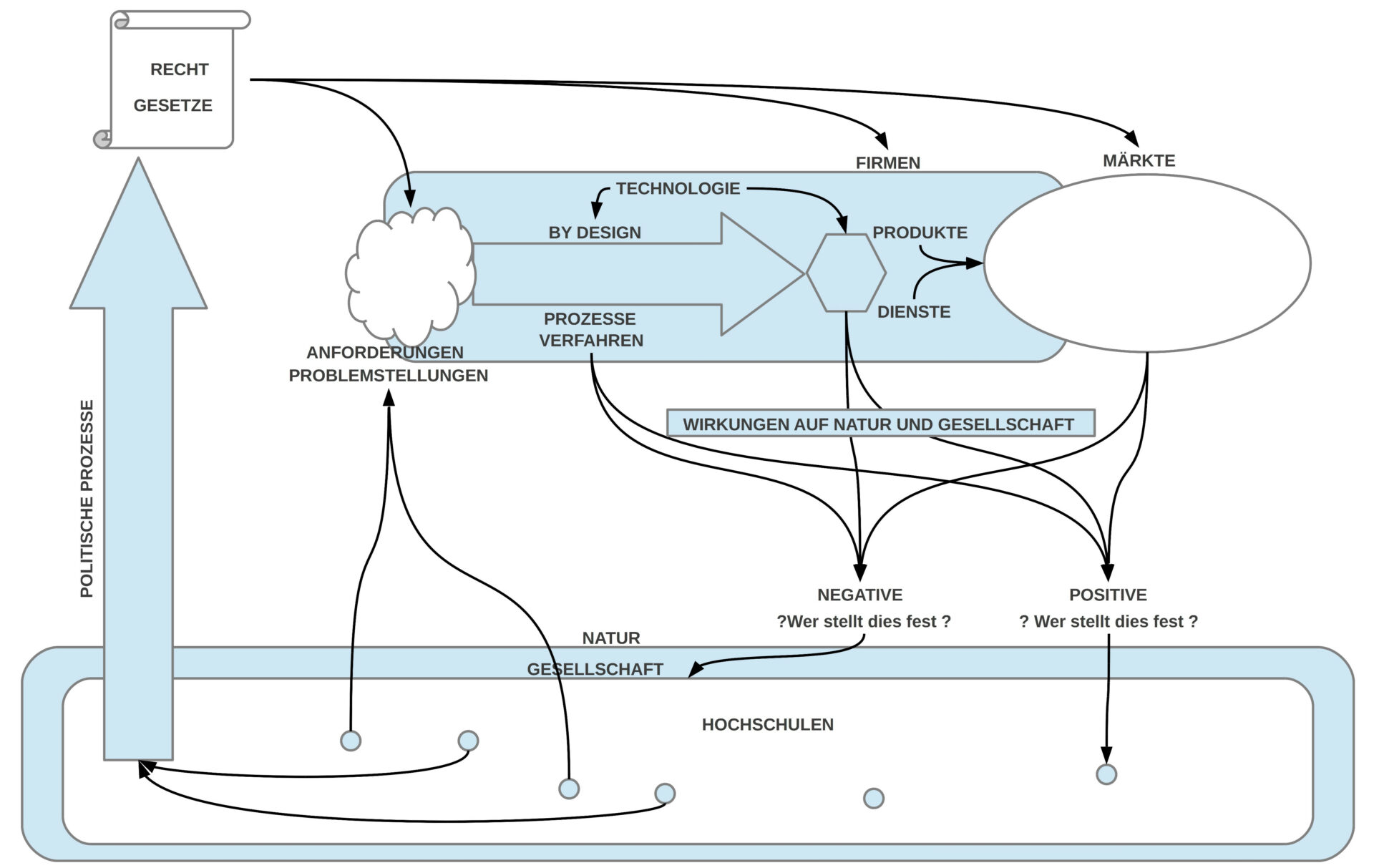

Wie schon zuvor angedeutet, muss der Ingenieur im Rahmen der Disziplin HCI/ HMI nicht nur die Anforderungen der Actor Story für eine Bewertung berücksichtigen, sondern zugleich — eher sogar zuerst (!)– gesellschaftliche Anforderungen, die z.B. in Form von rechtliche bindenden Verordnungen vorliegen können oder z.B. als ethische Anforderungen seines Berufsverbands.[21], [22], [23] Damit deutet sich an, dass es bei der Zielsetzung einer technischen Entwicklung nicht darum gehen kann, diese Aufgabe isoliert von der umgebenden gesellschaftlichen Situation zu sehen. In den letzten Jahren erweitert sich daher die Perspektive von HCI/ HMI zu dem erweiterten Kontext der umgebenden Gesellschaft.[11] , [11b] Für eine Arbeitsgruppe hatte ich mal folgende Skizze angefertigt:

In der Mitte der Skizze sieht man den Systems-Engineering Prozesspfeil. Sein Input kommt aus den Anforderungen (‚Requirements‘) der eigenen Firma aber auch von den Anforderungen der umgebenden Gesellschaft, speziell auch durch verabschiedete Gesetze. Die Ingenieure müssen versuchen, aus der Summe dieser Anforderungen (‚by design‘) technische Lösungen zu generieren, deren Wirkungen auf die Märkte wie auch auf die umgebende Natur und Gesellschaft möglichst nachhaltig sein sollten und möglichst wenig Schäden hervorrufen sollten. Ein offenes Problem ist es, welche Mechanismen in einer Gesellschaft existieren, welche möglichen negativen Auswirkungen festgestellt werden können und wie solche Feststellungen dann in eine entsprechende gesellschaftliche Willensbildung so umgeformt werden können, dass die durch Ingenieure verantworteten Entwicklungsprozesse möglichst nachhaltige Produkte erzeugen können.

DIGITALE SKLAVEREI vs. DIGITALES EMPOWERMENT

KOMMUNALE PLANUNG UND BÜRGER?

Mit der Ausdehnung des gesellschaftlichen Einflussbereichs auf potentielle Entwicklungsprozesse stellt sich irgendwann die Frage, wie sich die HMI-Expertengruppe eigentlich zusammen setzen soll? Schon in den 70iger und 80iger Jahren des 20. Jh waren die HMI-Experten vielfach und sogar überwiegend nicht mehr nur Ingenieure im klassischen Sinne sondern arbeiteten in Teams mit Psychologen in unterschiedlicher Ausprägung. Eines der einflussreichsten Bücher aus dieser Zeit heißt daher auch nicht zufällig The Psychology of Human-Computer Interaction. [12] Heutige HMI-Teams sind ebenfalls sehr gemischt.

Mit der immer stärker werdenden Verflechtung der Technologie mit der Gesellschaft stellt sich die Frage umso dringlicher und vielleicht noch radikaler..

Ich selbst wurde im Frühjahr 2018 als Informatiker (und für diese Veranstaltung speziell als KI Experte) von Städteplanern zu einer Konferenz eingeladen, in der es um die Planung resilienter Städten ging.[27] Auf den ersten Blick hat dies mit Computern nicht direkt etwas zu tun. Auf den zweiten Blick aber sehr wohl. Städte bilden eine aufregende Mischung aus einer Unzahl technischer Systeme (ein Haus ist heute ein hochkomplexes System, Verkehrsmittel, Versorgungseinrichtungen, usw.), die von einer immer größeren Zahl von Menschen alle gleichzeitig auf vielfache Weise genutzt werden. Es geht also um verteilte technisch Systeme mit verteilten Benutzern. Zusätzlich herrscht eine hohe Veränderungsdynamik, und alle Phänomene zusammen sind so komplex, dass heute weder ein einzelner Mensch noch eine beliebige Gruppe von Menschen — dazu zählen auch die vielen Behörden — realistischerweise all dies noch angemessen verstehen und planen kann.

Die lebhaften Diskussionen während dieser Konferenz führten zur spontanen Gründung einer Fachgruppe Kommunalplanung und eGaming am Forschungsinstitut der Architekten FFin an der FUAS.[13] Dies führte im Sommersemester 2019 zur Einführung eines neuen Moduls Kommunalplanung und Gamification. Labor für mehr Bürgerbeteiligung im Rahmen des interdisziplinären Studium Generale [ISG] der FUAS.[14]

Ziel der Arbeitsgruppe war und ist es, die Methode des Systems Engineering mit den Ingenieur-Experten als Handelnden so weit zu verallgemeinern, dass jeder Bürger als Experte gesehen werden kann, der zusammen mit anderen Bürgern auf neue Weise seine Zukunft mehr als bisher selbst gestalten kann.

Ein solches Ziel erscheint äußerst sinnvoll bedenkt man, wie wenig bislang die Bürger einer Kommune am tatsächlichen Planungsgeschehen beteiligt sind. Zugleich sind aber die bisherigen Gremien aufgrund ihrer begrenzten Ressourcen und Kompetenzen permanent überfordert. Und die junge Generation, für die die Fragen der Zukunft von höchster Bedeutung sind, die ist überall mehr oder weniger vollständig abseits des kommunalen politischen Geschehens.

DIGITALES EMPOWERMENT – EINE ANNÄHERUNG

Die ersten zwei Semester unseres forschenden interdisziplinären Lehrexperiments haben gezeigt, dass unsere Vermutung nicht ganz falsch waren. Wir benutzten dabei als Lernform die Form des Planspiels. [28]

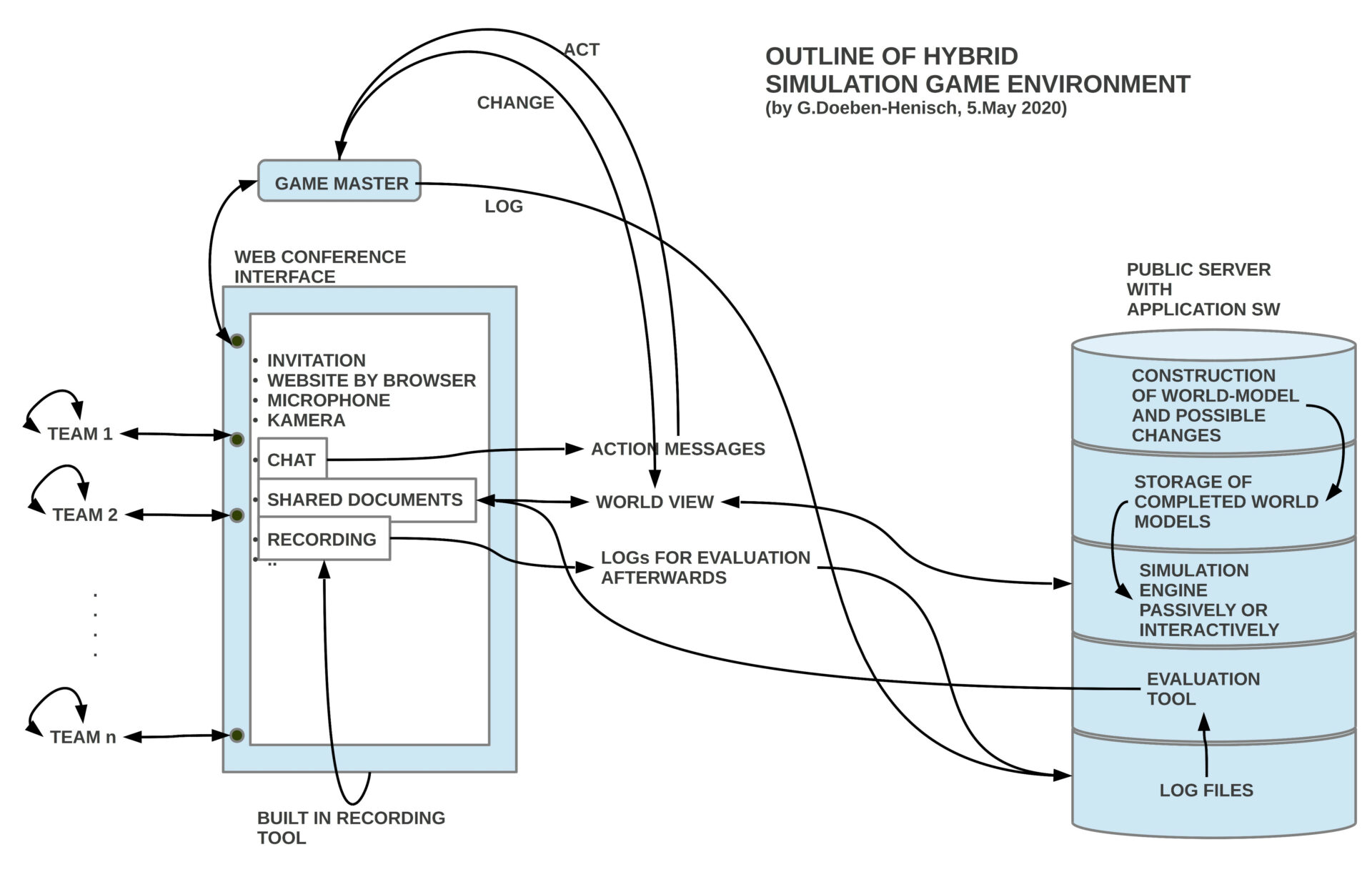

Das Auftreten der Corona-Epidemie kurz vor Beginn unseres 3.Semesters erwies sich im Nachhinein als eine starke Beschleunigung unseres Experimentes, da wir dadurch gezwungen wurden, kommunale Planungsprozesse als verteilte Planungsprozesse zu behandeln, die sich online praktizieren lassen.

Allerdings wurde uns klar, dass eine normale online-Konferenz, obwohl sie im Prinzip alle Möglichkeiten bot, die man für ein Planspiel benötigt, letztlich für das Konzept einer umfassenderen Bürgerbeteiligung — auch im Lichte der Engineering-Prozesse — unbefriedigend ist. Die Idee einer eigenen unterstützenden Software — die auch als Teil der Theorie zu einem integrierten Engineering schon immer als Forderung existiert hatte — wurde stärker und konkreter. Im September 2020, noch im Vorfeld des kommenden 4.Semesters, begann die Arbeit an einer speziellen Software (Doeben-Henisch, Tobias Schmitt).[29]

OKSIMO RELOADED – EINE SOFTWARE IST VERFÜGBAR

Der Name der neuen Software ist oksimo, aber da es vom Autor vor vielen Jahren ein Softwareprojekt gleichen Namens [20], allerdings mit einer vollständig anderer Architektur, gab, ist es korrekter von der aktuellen Software als oksimo reloaded Software zu sprechen.

Für die Studierenden wurde eine erste Version von oksimo reloaded am 4.Januar 2021 verfügbar. Ab dann konnten sie ihre Konzepte auf dem Server direkt ausprobieren. Parallel gab es eine Arbeitsgruppe des zevedi mit Standort im INM Frankfurt, die am Konzept einer Bürgerbeteiligung unter Zuhilfenahme der oksimo Software mit Bürgern aus einer hessischen Kleinstadt arbeitet.

ERKENNTISTHEORETISCHES

Da die neue Software in mehrfacher Weise einen radikalen Paradigmenwechsel vollzieht, gibt es verständlicherweise eine Reihe von Fragen, über die am Anfang viele stolpern. Eine Frage bezieht sich auf die Eigenschaft, dass der Benutzer dieser neuen Software keinerlei Programmiersprache benötigt, sondern nur seine Alltagssprache, und zwar nicht eine einzige, sondern jede ist möglich! Ob Deutsch, Englisch, Russisch, Chinesisch, Arabisch, das geht alles ohne irgend eine Änderung. Eine andere Frage bezieht sich darauf, was denn genau die Software beiträgt; wie kann sie normale Sprache verarbeiten? Die Antwort ist einfach: die Software muss überhaupt keine normale Sprache verarbeiten (was ja bekanntlich die besten Programme dieser Welt bisher nur sehr eingeschränkt können; letztlich gibt es noch kein einziges Programm weltweit, was tatsächlich normale Sprache unter voller Einbeziehung der Bedeutung verarbeiten kann. Es gibt bislang nicht einmal eine Idee, wie das gehen sollte, trotz vielen Hunderten von Artikel und Bücher zum Thema Sprachverarbeitung.). Die Faustregel lautet: Alles, was Anwender mit dem Programm machen können, können Sie auch ohne dieses Programm machen. Warum also überhaupt diese Software? Die Antwort ist einfach: sobald die Menge der benutzten Aussagen zunimmt (was schnell geschehen kann), dann ist eine rein manuelle Verarbeitung rein praktisch immer schwieriger bis praktisch unmöglich. In diesen Fällen kann man sich ganz entspannt zurück lehnen und den Computer für sich arbeiten lassen. Im übrigen ist das Ziel eines Einsatzes dieser Software gerade nicht, den Menschen zu ersetzen, sondern ganze Gruppen von Menschen anzuregen und zu befähigen, mehr als bisher miteinander ihr Wissen zu teilen, um damit ein Stück mehr mögliche gemeinsame Zukünfte sichtbar zu machen.

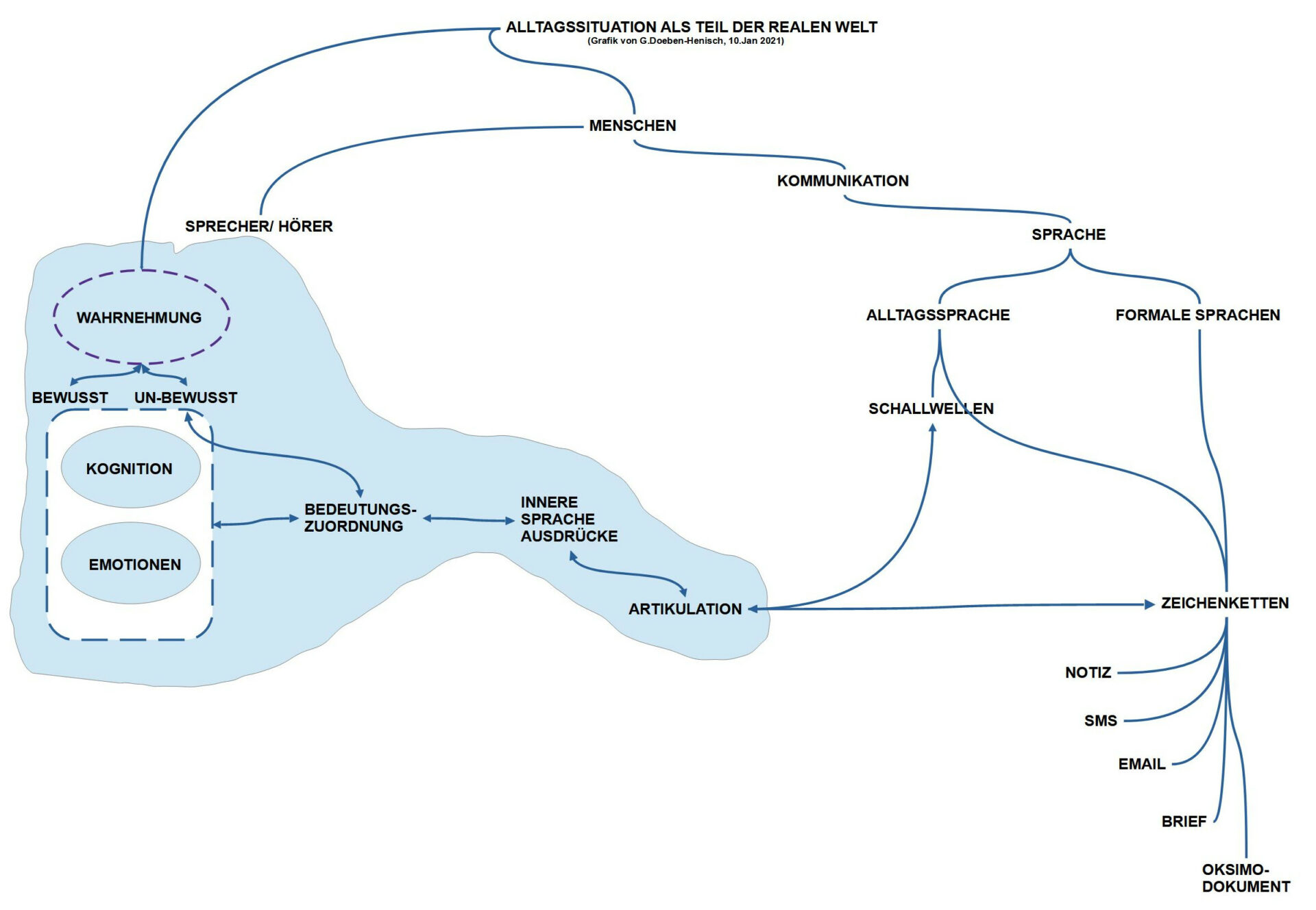

Für ein grundsätzliches Verständnis ist es wichtig, dass man sich klar machen, dass die gesprochenen Schallwellen von Sprache oder die geschriebenen Zeichenketten als solche keinerlei Bedeutung besitzen! Einzig und alleine aufgrund der Korrespondenz der externen Laute oder Zeichen mit internen Sprachrepräsentationen, die wiederum über interne Bedeutungsbeziehungen mit internen Wissensbeständen assoziiert sind, können die externen Vorkommnisse eine Bedeutung im Gehirn der Sprecher/ Hörer besitzen. Obwohl die internen Lernprozesse individuell verschieden sind, ermöglichen die gemeinsamen Gehirnstrukturen, die gemeinsamen Sprachstrukturen sowie ähnliche externe Erfahrungsräume für viele Fälle hinreichend ähnliche Bedeutungsstrukturen, die als Grundlage für ein gemeinsames Verstehen dienen können. Während also Menschen aufgrund ihrer erworbenen Sprachkompetenzen die Laute und Zeichen der ihnen vertrauten Sprache einfach so verstehen können, müsste man die — weitgehend unbewussten — Wissens- und Sprachstrukturen von Menschen erst in Computer hinein programmieren; ein bis heute ungelöstes Problem und in sich auch völlig unsinnig, besitzen doch die Menschen schon eine exzellente Sprachkompetenz (eine erste grundlegende Auseinandersetzung mit dem Thema, ob und wie Computer lernen können wie Menschen, findet sich von Alan M.Turing selbst 1948 in einem Bericht an das Nationale Physik Labor (NPL) von England, seinem damaligen Arbeitgeber. [30])

GROSSES POTENTIAL – KI ALS HILFSDIENST

Obwohl der Begriff Künstliche Intelligenz [KI] (Englisch: Artificial Intelligence [AI] — oft auch unter dem abschwächenden Begriff Maschinelles Lernen [ML] (Englisch: machine learning) — heute ein Mainstream-Begriff geworden ist, kann man nicht behaupten, dass es eine einheitliche Definition dieses wichtigen Begriffs gibt. Die EU Kommission hat sich 2019 für ihr Verständnis von KI — speziell auch im Kontext von Ethik-Fragen — auf eine Expertengruppe verlassen [17], die wiederum ein häufig verwendetes Lehrbuch zur KI [18] zitiert.

Ohne auf eine Diskussion dieser komplexen und unübersichtlichen begrifflichen Lage hier einzugehen, stelle ich hier einen Kerngedanken von KI vor, wie er auf alle Arten von sogenannten ‚intelligenten (smarten) Algorithmen‘ zutrifft und ordne dies in den Kontext dieses Beitrags ein.

Wie vorausgehend in der Diskussion des Themas Digitales Empowerment der Bürger verbunden mit dem Beispiel des Planspielkonzepts und der oksimo Software sichtbar wurde, bildet das Welt-Wissen aller Bürger einen offenen, dynamischen Raum, den man zwar durch immer wieder neue Beschreibungsversuche annähern kann, der aber sowohl durch das Verhalten der Bürger selbst wie auch der Dynamik der um gebenden Welt niemals in einem abgeschlossenen Zustand fixiert werden kann. Daraus ergibt sich notwendigerweise für die Kommunikation und Planung ein unabschließbares Prozessmodell. Dazu kommt noch ein weiteres: die Bürger müssen jederzeit ihre Ziele in diesem Prozess neu kalibrieren, gegebenenfalls abändern. In Abhängigkeit von diesen Zielen fallen die Bewertungen zur gegebenen Situation und zu möglichen Maßnahmen anders aus als bei den vorausgehenden Zielen.

Intelligente Algorithmen — sehr prominent z.B. AlphaGO von google [19] — sind in der Lage innerhalb eines definierten Suchraumes mit definierten Erfolgskriterien (oft auch fitness Werte genannt) aus den vielen möglichen Wegen von einem Start- zu einem Zielzustand diejenigen herauszufinden, die den größten Erfolg versprechen. Solange der Gegner — z.B. ein Mensch – langsamer ist in der Berechnung großer Datenmengen, wird solch ein Algorithmus ‚besser‘ sein. Viele Menschen — und speziell das Marketing großer Firmen, die verkaufen wollen oder die Propaganda-Organe autoritärer Staaten — ziehen daraus den Schluss, dass die Zeit des Menschen abgelaufen ist. Dies ist ein arger Fehlschluss. Würde man den intelligenten Algorithmen die Erfolgskriterien wegnehmen, währen sie mehr oder weniger nutzlos. Geschwindigkeit ersetzt nicht den Mangel an Zielen.

Das oksimo reloaded Programm sieht einfach aus, es besitzt aber eine dreifache Intelligenz-Dimension: (i) Die volle (kreative) Intelligenz der Menschen kann in das Programm eingehen, in natürlicher Sprache! (ii) Teil der menschlichen Intelligenz ist die Fähigkeit, Ziele zu formulieren und danach zu handeln, diese Ziele aber auch zu modifizieren; (iii) Dort, wo die Komplexität des Problems für menschliche Gehirne rein quantitativ zu mühsam wird, kann man intelligente Algorithmen aktivieren, die diese mühsame Arbeit im vorgegebenen Rahmen leisten. In diesem Kontext können diese Algorithmen so schnell wie möglich sein. Sie sind dann nur nützlich. Diese Algorithmen können aber das Problem der gewollten Ziele nicht lösen. KI im Kontext der oksimo Software könnte man daher mit dem Slogan beschreiben: Paradigmenwechsel: KI für Alle! Mehr Leistung – Null Risiko.

Wissenschaftsphilosophisch kann man den oksimo-Ansatz in folgende Teil-Paradigmen aufspalten:

- Human-Machine Intelligence [HMInt] (Mensch-Maschine Intelligenz): Primär dient der Mensch selbst mit seiner menschlichen Intelligenz als Wissensquelle und Handlungsinspiration. Die volle Breite der künstlichen Intelligenz kann aber genutzt werden.

- Human-Machine Interaction [HMI] (Mensch-Maschine Interaktion): Die Intelligenz- bzw. Wissens- bzw. Zielfrage wird analysiert im größeren Kontext der generellen Mensch-Maschine Interaktion, die in Richtung der umgebenden Gesellschaft offen ist; keine festen Limits.

- HMI als Teil des Systems Engineering [HMI-SE]: Der Teilaspekt der Mensch-Maschine Interaktion wird innerhalb des größeren, allgemeineren Rahmens Systems Engineering gesehen.

- Innerhalb des Alltags gibt es als allgemeinste Reflexionsform das philosophische Denken, das in offenem Austausch steht mit Kunst, mit Engineering und Wissenschaft. Alle diese drei Bereiche haben Voraussetzungen, die nicht Teil ihrer eigenen Gegenstandsbereiche sind, zugleich sind sie originär, nicht auflösbar in die anderen Teilbereiche.

RESUMÉ: INGENIEURE UND DAS GLÜCK

Nachdem wir nach all diesen — nicht ganz leichten — Überlegungen bis zu diesem Punkt der Überlegungen gekommen sind, werden Sie vielleicht ahnen können, auf welchen Punkt ich hinaus möchte.

Ist es schon nicht ganz einfach, in einer gegenwärtigen Situation problematische Sachverhalte zu identifizieren — ich erinnere an die heftigen Diskussion um die Frage Klimakrise: Ja oder Nein? bzw. Corona: Gefährlich oder nicht? — so ist der Übergang von einer Problemwahrnehmung zur Formulierung einer Lösungsidee, eines möglichen Zieles in der Zukunft, kein Selbstläufer. Und selbst dann, wenn wir endlich Ziele haben sollten, dann beginnt die eigentliche Arbeit nach der Zielformulierung: wie kommen wir vom Jetzt zum Morgen? Was müssen wir tun? Die anhaltenden kontroversen Diskussionen um eine mögliche Energiewende, wie die genau aussehen soll usw. beschäftigt uns seit vielen Jahren und eine wirkliche Einhelligkeit ist nicht wirklich in Sicht.

Nehmen wir mal versuchsweise und positiv denkend an, dass wir nur solche Ziele formulieren, von denen wir mehrheitlich annehmen, dass sie unser gemeinsames Glück fördern — in der US-Amerikanischen Verfassung ist das Erstreben von Glück als unveräußerliches Recht von jedem verankert [3] — dann wird hoffentlich augenscheinlich klar, dass viele Formen des Glücks ohne die tatkräftige und kundige Mitwirkung von Ingenieuren nicht einlösbar sind.

Ein Großteil der der drängenden Probleme in Deutschland resultieren nicht aus falschem Verhalten von Ingenieuren, sondern aus einem z.T. gravierenden Unverständnis der Politischen Gremien. Was natürlich die Frage aufwirft, warum sind so wenig Ingenieure in der Politik?

QUELLENANGABEN

(Wenn nicht anders angegeben sind alle Links am 12.1.2021 zuletzt überprüft worden)

[0] Videomitschnitt vom Vortrag: https://www.youtube.com/watch?v=fN-ZrIqd2Lk&feature=youtu.be. Die Vortragsreihe der Studierenden findet sich hier: http://studiumfuturale.000webhostapp.com/ (zuletzt: 18.1.2021)

[1] Zum Begriff des ‚Ingenieurs‘: https://de.wikipedia.org/wiki/Ingenieur (zuletzt: 11.1.2021)

[2] Zum Begriff des Glücks: https://de.wikipedia.org/wiki/Gl%C3%BCck (zuletzt: 11.1.2021)

[3] Erreichung von Glück in der US-Amerikanischen Verfassung: https://en.wikipedia.org/wiki/Life,_Liberty_and_the_pursuit_of_Happiness (zuletzt: 11.1.12021)

[4] FUAS: https://www.frankfurt-university.de/ (zuletzt: 11.1.2021)

[5] FUAS Fb2: Informatik und Ingenieurwissenschaften: https://www.frankfurt-university.de/de/hochschule/fachbereich-2-informatik-und-ingenieurwissenschaften/willkommen-am-fb-2/ (zuletzt: 11.1.2021)

[6] FUAS Fb2 Themengebiete: https://www.frankfurt-university.de/de/hochschule/fachbereich-2-informatik-und-ingenieurwissenschaften/studienangebot-am-fb-2/ (zuletzt: 11.1.2021)

[7] Jakob Johann Baron von Uexküll (1864 – 1944) : https://de.wikipedia.org/wiki/Jakob_Johann_von_Uexk%C3%BCll (zuletzt: 11.1.2021)

[7b] Jakob von Uexküll, 1909, Umwelt und Innenwelt der Tiere. Berlin: J. Springer.

[8] Systems Engineering: https://en.wikipedia.org/wiki/Systems_engineering (Zuletzt: 11.1.2021)

[8b] L. D. Erasmus and G. Doeben-Henisch, A Theory of the System Engineering Process in 9th IEEE AFRICON Conference in Africa, Sept. 12-15, 2011 (This paper has won a paper award)

[9] HCI History: http://www.hcibib.org/hci-sites/history

[9b] Jonathan Grudin. A Moving Target: The Evolution of HCI.In A. Sears and J.A. Jacko, editors,The Human-ComputerInteraction Handbook. Fundamentals, Evolving Technologies,and emerging Applications. 2nd edition, 2008.

[9c] Joseph S. Dumas and Jean E. Fox. Usability testing: Currentpractice and future directions. In J.A. Jacko and A. Sears, editors, The Human-Computer Interaction Handbook. Fundamentals, Evolving Technologies, and Emerging Applications. 2nd edition,2008

[10] HCI als Teil des Systems Engineering praktiziert vom Autor: https://www.uffmm.org/wp-content/uploads/2019/05/aaicourse-15-06-07.pdf

[11] Doeben-Henisch (2020), Review of Tsu and Nourbakhsh (2020), When Human-Computer Interaction Meets Community Citizen Science. Empowering communities through citizen science. In the Proceedings of the 2017 CHI Conference on Human Factors in Computing Systems, ACM 2017: https://www.uffmm.org/wp-content/uploads/2019/06/review-Tsu-et-2020-acm-CommunitySciences.pdf

[11b] Randy Conolly, 2020, Why Computing Belongs Within the Social Sciences, COMMUNICATIONS OF THE ACM, AUGUST 2020, VOL. 63, NO. 8, pp. 54 – 59

[12] Stuart K.Card, Thomas P.Moran, Allen Newell [1983], The Psychology of Human-Computer Interaction, Lawrence ERlbaum Associates, Inc., Mahwah, New Jersey

[13] FFin an der FUAS: https://www.frankfurt-university.de/de/hochschule/fachbereich-1-architektur-bauingenieurwesen-geomatik/forschungsinstitut-ffin/

[14] ISG-Modul Kommunalplanung und Gamification… : https://www.frankfurt-university.de/de/studium/interdisziplinares-studium-generale/interdiszplinares-studium-generale-modulpool-wise-202021/kommunalplanung-und-gamification-labor-fuer-direkte-buergerbeteiligung/

[15] Aristoteles. Peri Hermeneias. Aristoteles Werke in Deutscher Übersetzung. Akademie Verlag, 1994. Bd.1, Teil 2

[16] oksimo simple basic version vom 3.Januar 2021: https://www.uffmm.org/2021/01/08/oksimo-sw-minimal-basic-requirements/

[17] Stuart Russel and Peter Norvig. Artificial Intelligence. A Modern Approach.

Pearson Education, Inc. publishing as Prentice Hall, 3 edition, 2010

[18] INDEPENDENT HIGH -LEVEL EXPERT GROUP ON ARTIFICIAL INTELLIGENCE SET UP BY THE EUROPEAN COMMISSION. Definition developed for the purpose of

the AI HLEG’s deliverables. The AI HLEG is an independent expert group that was set up by the European Commission in June 2018. Contact E-mail Nathalie Smuha – AI HLEG Coordinator

CNECT-HLG-AI@ec.europa .eu

European Commission

B-1049 Brussels

Document made public on 8 April 2019 URL: https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=56341 (Zuletzt: 12.1.2021)

[19] Googles AlphaGo Programm: https://en.wikipedia.org/wiki/AlphaGo

[20] Ursprüngliches oksimo-Projekt: https://de.wikipedia.org/wiki/Oksimo

[21] Ethischer Verhaltenskodex des Berufsverbands der IEEE: https://www.ieee.org/about/ethics/index.html

[22] Ethischer Verhaltenskodex des Berufsverbands der ACM: https://www.acm.org/code-of-ethics

[23] Ethischer Verhaltenskodex des Berufsverbandes der GI: https://gi.de/ueber-uns/organisation/unsere-ethischen-leitlinien/

[24] Übersichtsartikel zu Sklaverei: https://de.wikipedia.org/wiki/Sklaverei

[24b] Doeben-Henisch, Zum Thema Freiheit, Menschenrechte und Sklaverei: https://www.cognitiveagent.org/2018/11/19/freiheit-die-ich-meine-nachhall-zu-einem-gespraech/

[25] UN 4. Supplementary Convention on the Abolition of Slavery, the Slave Trade, and Institutions and Practices Similar to Slavery. Geneva, 7 September 1956: https://treaties.un.org/doc/Treaties/1957/04/19570430%2001-00%20AM/Ch_XVIII_4p.pdf

[26] Gerd Doeben-Henisch (gerd@doeben-henisch.de), MENSCH-MENSCH COMPUTER. Gemeinsam Planen und Lernen. Erste Notizen. Abfassungszeit: 23.September – 9.Oktober 2020, Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, URL: https://www.cognitiveagent.org/wp-content/uploads/2020/10/blog-welt-mensch-theorie-23sept-9Okt2020.pdf

[27] Gerd Doeben-Henisch, 2018, Ballungsraum 2117 und technische Superintelligenz. Welche Rolle verbleibt uns Menschen?, Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 14.April 2018, URL: https://www.cognitiveagent.org/2018/04/14/ballungsraum-2117-und-technische-superintelligenz-welche-rolle-verbleibt-uns-menschen/

[28] Gerd Doeben-Henisch, 2019, GRENZEN IM KOPF VERFLÜSSIGEN? Eine unterschätzte Methode, Journal: Philosophie Jetzt – Menschenbild, ISSN 2365-5062, 5.November 2019, URL: https://www.cognitiveagent.org/2019/11/05/grenzen-im-kopf-verfluessigen-eine-unterschaetzte-methode/

[29] Beginn der Arbeiten an der neuen Software für das Modul Kommunalplanung und Gamification. Labor für mehr Bürgerbeteiligung: URL: https://www.uffmm.org/2019/04/01/co-learning-with-python-3/ (In der späteren Phase fanden die Programmierarbeit ausschließlich auf dem Server statt unter Benutzung eines github Accounts).

[30] Alan M. Turin schrieb 1948 den ersten grundlegenden Bericht darüber, wie Computer eventuell wie Menschen lernen können. Auf der Webseite der NPL (National Physics Laboratory, England) zu Turing ( https://www.npl.co.uk/famous-faces/alan-turing ) finden sich dieser Artikel und zusätzliche Texte: https://www.npl.co.uk/getattachment/about-us/History/Famous-faces/Alan-Turing/80916595-Intelligent-Machinery.pdf?lang=en-GB. Eine bessere lesbare Form findet sich hier: https://weightagnostic.github.io/papers/turing1948.pdf

NACHWIRKUNGEN

Dieser Vortrag war die Initialzündung zu sehr vielen Beiträgen in diesem Blog. Eine sehr spezielle — und vermutlich sehr nachhaltige — Wirkung kann man ab dem Beitrag hier verfolgen: https://www.cognitiveagent.org/2021/02/12/praktische-kollektive-mensch-maschine-intelligenz-by-design/

DER AUTOR

Einen Überblick über alle Beiträge von Autor cagent nach Titeln findet sich HIER.